壹 前言

隨著人工智慧與雲端運算快速發展[1],資料中心面臨前所未有的高熱功耗密度挑戰。傳統的氣冷式散熱技術已逐漸無法滿足高效能伺服器的散熱需求,不僅降低能源使用效率,也提高整體營運成本,在此背景下,液冷技術逐漸成為主流,目前主要分為直接液體冷卻(Direct Liquid Cooling, DLC)與浸沒式冷卻(Immersion Cooling)兩大類,直接液體冷卻已廣泛應用於高功耗晶片的散熱,但隨著晶片耗能持續攀升,浸沒式冷卻技術則將伺服器直接浸入絕緣冷卻液中,可進一步提升散熱效率,因此被視為新世代資料中心散熱的終極技術。

貳 散熱技術發展現況

一、 伺服器晶片功耗不斷升高

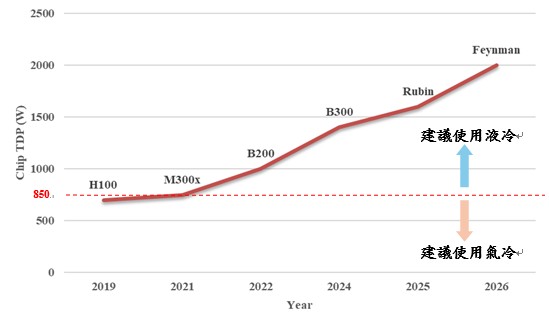

資料中心的主要耗電來源為IT設備與散熱系統,合計佔整體用電超過九成[2]。隨著生成式 AI的快速崛起,無論是企業積極布局AI商機,或各國推動「算力即國力」的戰略皆使GPU的算力需求持續攀升。為了提升效能,高階GPU的更新速度加快,伺服器的運算能力與晶片運行頻率同步提升,導致功耗不斷上升。以NVIDIA為例,2022年推出的H100晶片,其熱設計功耗(Thermal Design Power, TDP)已達0.7kW;2024年的B200更提升至1kW,預計2025 年下半年推出的B300有機會突破1.4kW,遠超過氣冷技術約0.85kW的散熱極限。如圖 1 所示,散熱壓力日益加劇,使液冷技術成為高階GPU散熱的唯一選項[3]。目前功耗最高的GB200超級晶片由Grace CPU與兩顆B200 GPU組成熱功耗高達2.7kW,就是採用液冷技術進行散熱。隨著NVIDIA將液冷散熱做為GPU晶片散熱的標準配備,帶動周邊相關廠商也將直接液體液冷卻技術做為高熱密度功率晶片的標準配備。但直接液體液冷卻技術單晶片的散熱能力上限為1.5kW,隨著GPU晶片熱功耗逐年攀升,可以預見具有更高散熱能力的浸沒式冷卻技術將會是新一代AI伺服器晶片散熱的另一選項。

二、 資料中心伺服器散熱朝液冷發展

資料中心的能源效率通常以電力使用效率(Power Usage Effectiveness, PUE) )做為衡量指標[4],定義為總用電量與實際供應給IT設備的用電量之比。理想狀況下PUE為1,代表所有電力皆用於運算,但因散熱、照明與電力轉換等設備的基本能耗,PUE通常高於1。隨著伺服器機櫃功率密度不斷提升,傳統氣冷式散熱面臨瓶頸,散熱技術不僅影響能源效率與營運成本,更直接關係到設備的穩定性與壽命。

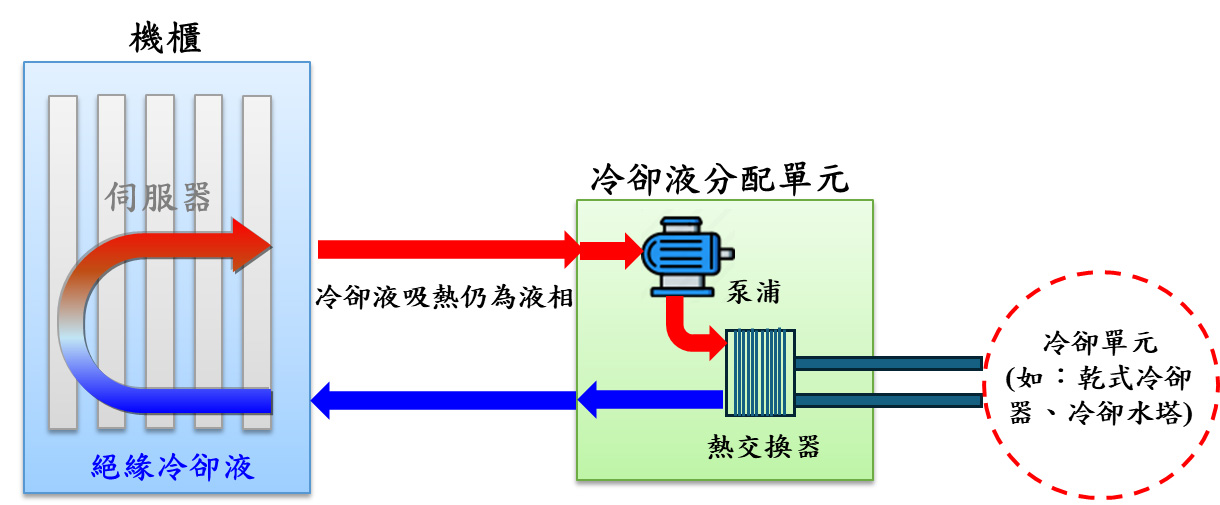

傳統氣冷式散熱係透過冷空氣流入伺服器前端帶走熱量進行散熱,再將熱空氣回流至空調系統進行熱交換並持續循環。效能較佳的資料中心其PUE約為1.6,但隨著伺服器CPU/GPU功耗大幅上升,氣冷效率已無法滿足高功耗密度的散熱需求。直接液體冷卻技術利用液冷板緊貼CPU/GPU等高熱散逸晶片的表面,將熱量迅速傳導至流動的冷卻液中,再經過熱交換器將熱量排出,由於液體熱傳效率遠高於空氣,此技術可有效應對熱功耗1.2~1.5kW [5]的晶片之散熱需求,因為是藉由液體循環散熱,資料中心的空調系統就可省卻氣體循環設備相關的電力需求,進而大幅降低空調系統的用電,使資料中心 PUE 可降至 1.2 以下。儘管液冷系統需額外配置冷卻液分配單元(Coolant Distribution Unit, CDU)與液路管線,但相較於氣冷系統可省卻了風管、鼓風機等設備,整體空間與電力需求大幅降低,且可直接改建氣冷式散熱資料中心,具高度相容性,成為目前AI資料中心的主流散熱方案。

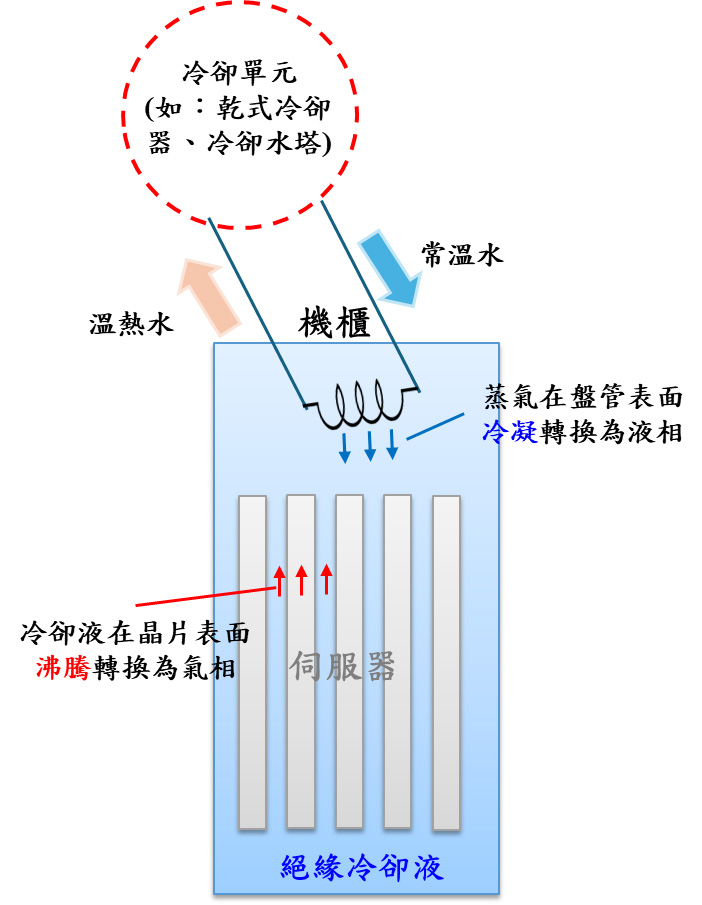

然而,隨著晶片功耗持續攀升,直接液體冷卻可能面臨散熱熱阻無法再降低、熱點難以完全消除及低碳排放資料中心趨勢等問題,可能無法應對更高散熱需求與更低的電力消耗趨勢,此時,勢必使用散熱效能更高,電力需求更低的浸沒式冷卻技術方能滿足未來高功耗晶片與資料中心低碳排的發展趨勢。浸沒式冷卻技術具有更低的熱阻係數(可均勻且高效的將熱帶走),能消除局部熱點現象,以及極低的電力需求(僅有低功耗的液體循環泵浦),顯著提升散熱效率和節能效果,將資料中心的PUE下降至1.1以下。

三、 新世代浸沒式冷卻技術

浸沒式冷卻技術因具備高效散熱能力與低能耗,被視為液冷技術的未來發展方向,將整台伺服器浸入絕緣冷卻液中,液體直接接觸晶片表面,能均勻吸收並迅速帶走熱量,有效解決高熱密度晶片散熱不均的問題。依冷卻液的運作方式,浸沒式冷卻技術可分為以下兩種:

浸沒式冷卻技術具備優異的散熱效能與節能潛力,且可移除風管、鼓風機與複雜液路設計,不僅降低噪音[7]與設備維護成本,也提升系統穩定性與可靠性。根據2024年Gartner的報告[8],浸沒式冷卻技術預期將在未來幾年內趨於成熟,並成為新一代AI伺服器晶片散熱的重要選項,廣泛應用於資料中心、邊緣運算及5G基地台等高密度運算場域。

參 浸沒式冷卻技術發展仍待突破

儘管浸沒式冷卻技術具備優異的散熱效能與節能潛力[9],但在推廣與應用上仍面臨多項挑戰。首先,由於伺服器需整機浸入冷卻液,系統重量大幅增加,現有資料中心需強化結構承載能力並重新規劃建置設計,導致初期投入成本偏高;其次,浸沒式冷卻技術的維運管理相較於氣冷式散熱與直接液體冷卻技術更為複雜,各家設備規格尚未統一,伺服器更換時需從冷卻液中取出並防止液體外洩,操作流程須嚴格遵循標準作業程序,增加維護難度。此外,冷卻液的長期穩定性及對伺服器元件的影響仍待持續驗證,亦存在環保與回收的疑慮,目前產學研界正積極研發低毒性、可回收且低碳排放的冷卻液材料,並推動相關標準的建立。整體而言,浸沒式冷卻技術具備成為未來資料中心主流散熱技術的潛力,但要邁向大規模應用,仍需在技術成熟度、成本效益與標準化等層面持續突破。

肆 結論

隨著人工智慧與雲端運算快速發展,資料中心在散熱與能耗之間面臨日益嚴峻的挑戰。雖然浸沒式冷卻技術尚未完全成熟,但傳統氣冷與直接液體冷卻已逐漸難以應付高效能運算設備的散熱需求。浸沒式冷卻技術具備極佳的散熱效能,能有效提升能源使用效率、降低PUE,並減少噪音,有助於打造綠色永續的資料中心。目前,浸沒式冷卻設備廠商正積極優化機櫃設計與維運模式。例如,英業達已支援單片主機板的熱插拔維護,力致則透過自動化機械手臂,在不改變原有主機板設計的前提下,實現主機板的自動更換[10]。這些創新大幅降低維運難度,提升可維護性與操作便利性。隨著浸沒式冷卻技術在設計成熟度、標準化推廣及冷卻液環保性能上的持續進展,其應用前景正逐步擴展,此技術不僅能降低能耗與碳排放,亦可提升資料中心效能與穩定性。未來,浸沒式冷卻技術有望成為資料中心散熱架構中的關鍵選項之一,與其他技術共同構築多元且永續的散熱解決方案。

伍 參考文獻

[1] MIC, “台灣資料中心發展趨勢分析”, March 2025.

[2] MIC, “Green AI vs. Gen AI對資料中心發展趨勢” , September 2024.

[3] MIC, “液體冷卻方案導入資料中心之影響”, January 2025.

[4] MIC, “從氣冷到液冷:散熱技術發展趨勢與臺灣產業動態” , November 2024.

[5] Digitimes, “半導體與電子產業” , August 2024.

[6] IEK, “【能源效率減碳解決方案】資料中心散熱利器-沉浸式冷卻技術”

[7] MIC, “AI資料中心市場發展與關鍵議題”, April 2024.

[8] Gartner, “Hype Cycle for Data Center Infrastructure Technologies, 2024”.

[9] E-Abel, “資料中心冷卻技術綜合指南”, November 2024.

[10] MIC, “Computex 2025資料中心用液冷散熱及BBU發展動向” , June 2025.