壹 前言

生成式AI技術蓬勃的發展,不僅在大型語言模型有重大突破,多媒體領域中的圖像生成已經能根據真人給出的想法,生成對應的藝術風格影像,語音合成則只需要幾秒鐘的錄音,即可模仿真人說話。這些強大的技術已經讓真實與虛擬之間的界線變得模糊,人類很難分辨出這些影音內容是由真人還是AI生成的。

然而,這些技術除了能夠創造逼真且多樣化內容豐富我們的生活外,也帶來許多風險,如影音深度偽造 (Deep Fakes)、影音原創性抄襲 (Plagiarism)、語者冒充 (Impostor)等、創造特定意圖的影音來散播假消息甚至行使詐騙。因此,資料保護與認證問題已經被各國政府重視。

本文將介紹影音浮水印 (Multimedia Watermarking)技術,它是一種能夠透過添加數位浮水印在影音內容中,保護與驗證影音內容。最新的方法已經能夠在不影響使用者體驗的前提下,為影音內容添加驗證內容,即使在複製和傳播的過程中,仍然能夠追蹤,維護作者的權益。

貳 科技發展現況

一、 影音浮水印技術簡介

■ 疊加式浮水印 (Overlay Watermark)

疊加式浮水印技術係利用半透明的方式,將欲加入資訊透過數位浮水印疊加於影音中,如圖一所示。這種方法雖然可以輕易的加入資訊,但有明顯的缺點,也就是加入浮水印的影像肉眼可見且語音品質聽感受影響,使用者體驗不佳之外,亦容易被有心人士使用影音編輯軟體去除版權浮水印。

■ 隱藏式浮水印 (Steganography watermark)

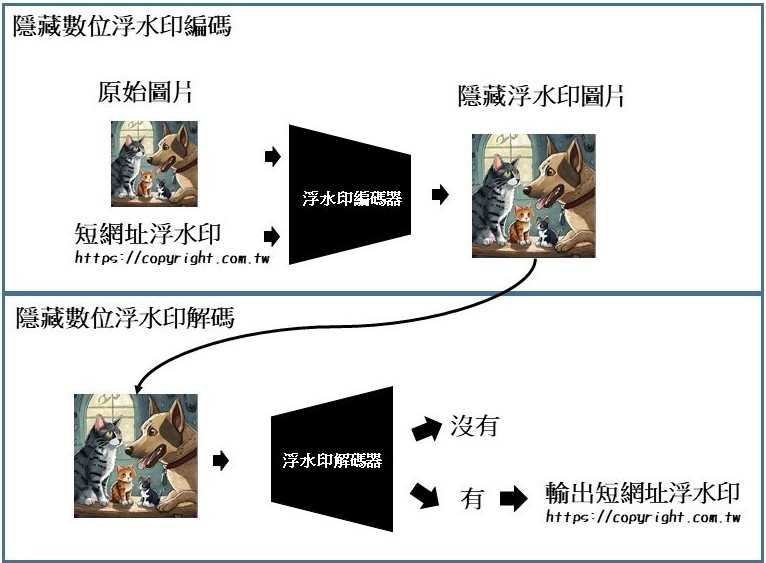

隱藏式浮水印方法係將數位浮水印隱藏嵌入影音中,使數位浮水印不影響視覺與聽覺,盡可能保持原始資料的影像色彩、聲音清晰度。目前主流的隱藏式浮水印技術是一種基於AI開發的方法 [1-3],由編碼器 (Watermark Encoder) 與解碼器 (Watermark Decoder) 所組成,圖二展示如何用短網址作為數位浮水印編碼進圖片中。首先,輸入原始影像與數位浮水印,透過編碼器將數位浮水印編碼進影像中,編碼後的影像與原始影音,人眼並不會感受到差異,使用者便可以發佈已加入數位浮水印的影像而不被察覺。當影音來源需要被驗證時,輸入一段影音到浮水印解碼器,解碼器先確認此段影音浮水印是否包含數位浮水印,接著輸出數位浮水印內容。

■ 隱含浮水印生成模型 (Watermarking Generative Model)

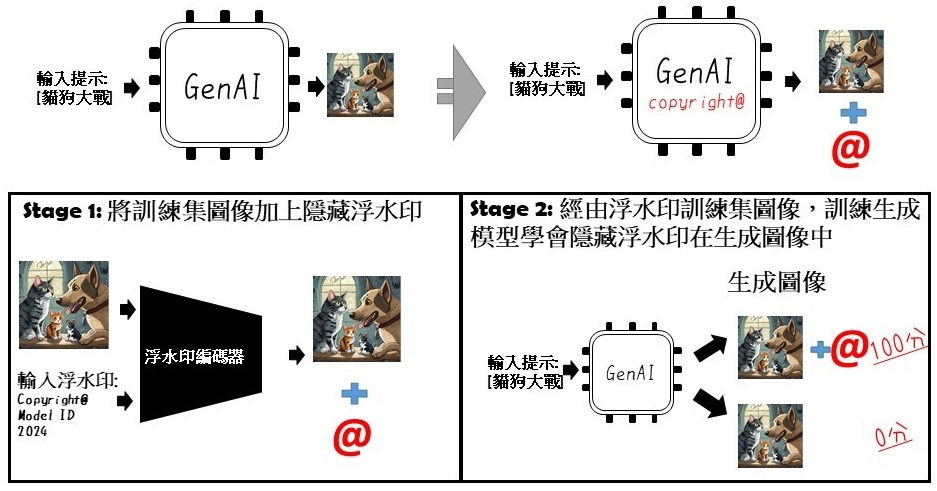

近來火熱生成模型,包含對抗生成模型 (Generative Adversarial Neural networks, GANs)及去噪擴散模型 (Denoising Diffusion Probabilistic Models, DDPM),都有能力利用文生圖 (Text to Image)和文生語音 (Text to Speech) 的方式生成非常逼真的資料。在AI生成模型生成資料時,若同時隱含數位浮水印,則可以溯源資料產生模型與區分真實世界資料 [4-5] 。圖三展示如何使文生圖AI生成模型在產生資料的同時包含數位浮水印,首先,利用隱藏式浮水印的編碼器將訓練資料加入數位浮水印,接著利用這些資料再訓練生成模型,透過學習的過程,模型學會產生影音需包含隱藏數位浮水印。

二、 影音浮水印技術應用

■ 保護原創者資料

影像浮水印技術被應用在新興媒體和電視產業,能夠確保原創內容的保護與合法授權使用。聲音浮水印技術幫助音樂產業版權所有者追蹤和管理音樂作品、歌手聲音的使用,防止盜版和非法複製分享。語音識別、語音浮水印驗證等領域,則提供語音數據的安全性和溯源性。

■ 生成資料安全性

生成資料辨識 (Detecting generated contents) 提供人們辨識資料來自真實世界或是由模型生成能力,因為這直接影響數據的可信度與使用範圍。例如2024年許多國家大選即將登場,生成式AI提供媒體、競選人產生各種新聞與文宣,但若利用AI產生針對移民政策、墮胎議題、跨性別權利、俄烏戰爭等議題內容,試圖影響其他選民或媒體,則可能影響選舉結果。

■ 生成模型版權保護

生成式模型是由各公司或學校花費大量資源開發訓練的,它包含了開發者的創意與技術,保護生成模型版權可以使開發者享有他們的知識產權,從而促進創新與技術發展。

■ 實際應用

Adobe、OpenAI、 Google、Microsoft等公司結盟創立的開放技術標準內容來源和真實性聯盟C2PA (Coalition for Content Provenance and Authenticity) [6],對生成AI資料制定了通用的規範,讓企業、媒體或其他使用人員可以在影音中嵌入溯源的出處,C2PA規範適用於生成圖片、真實相片與各種多媒體業。

相機大廠Nikon、Sony、Canon已經導入浮水印技術於相機韌體,在拍攝同時嵌入數位簽章於照片中,替真實相片加入認證,除了保護攝影者版權之外,也能抵制不實訊息利用生成相片傳播 [7]。

OpenAI旗下的影像生成工具DALL·E3,基於C2PA規範將圖像加上數位憑證,同時提供Content Credentials verify網站來可以識別是否圖像為DALL·E3 模型產生的圖像。Google DeepMind最新發表的SynthID技術 [8],將浮水印加在由Imagen生成模型產生的資料,將浮水印隱藏在聲音與圖像中,並且可以使用他們的浮水印偵測器,將圖片中的浮水印提取出來。

語音合成軟體Respeecher在他們的生成聲音語料庫Voice Marketplace中使用具有符合C2PA 規範的不可見數位浮水印 [9-10]。每次生成合成音頻時,它都會自動加密簽名以驗證來源。下載音頻時,客戶會收到內容憑證,證明音頻是由Respeecher轉換的,使用者能夠輕鬆驗證內容的真實性。

三、 影音浮水印技術的挑戰

■ 影音品質

隱藏浮水印的影音品質不能受到影響,文獻顯示,當浮水印資訊量越大,影音品質下降越明顯。因此,如何在隱含足夠的有效版權資訊的同時,保持影音品質至關重要。

■ 浮水印的安全性

有心人士能夠透過簡單的影音編輯消除浮水印,如何避免浮水印可以被輕易地透過影像或語音編輯而破壞或移除,目前的解決方法是攻擊模擬。這種方法模擬了各種攻擊浮水印影音的行為,影像浮水印的攻擊利用圖像基本運算模糊消除浮水印,如影像縮放(scaling)、影像旋轉 (rotate)、影像插值 (interpolation)、影像壓縮(compression)、影像濾波 (filtering)。聲音浮水印的攻擊則包括像語音重新採樣(Re-Sampling)將語音的採樣率轉為一半,然後再轉回原始採樣率,語速更改(Time Stretch)將語音速率增加或減少10%,回音添加(Echo Addition)透過添加語音回音,以及各種訊號濾波器(Signal Filter)濾除特定頻帶的訊號等。模型透過這些攻擊訓練,可以學會如何避免這些攻擊。但是,攻擊模式日新月異,許多技術推出後,短時間內就遭人破解,因此我們需要隨時更新我們的策略應變。

參 結論

中華電信研究院作為致力於發展最新AI技術的研發機構,有責任確保AI產品在推向市場之前是安全可靠的,並保證生成式AI技術的應用能在合法的框架下進行,因此多媒體浮水印作為一種版權保護技術,具有重要的研究價值與應用前景,從而為客戶提供更安全、更可靠、更優質的服務和產品體驗。

肆 參考文獻

[1] ROMAN, Robin San, et al. Proactive Detection of Voice Cloning with Localized Watermarking. arXiv preprint arXiv:2401.17264, 2024.

[2] Watermarking for audio generation. arXiv preprint arXiv:2308.12770, 2023.

[3] ZHONG, Xin, et al. An automated and robust image watermarking scheme based on deep neural networks. IEEE Transactions on Multimedia, 2020, 23: 1951-1961.

[4] Yunqing Zhao, Tianyu Pang, Chao Du, Xiao Yang, Ngai-Man Cheung, and Min Lin. A recipe for watermarking diffusion models. arXiv preprint arXiv:2303.10137, 2023.

[5] LIU, Yugeng, et al. Watermarking diffusion model. arXiv preprint arXiv:2305.12502, 2023.

[6] C2PA. (n.d.). C2PA. Retrieved from https://c2pa.org/

[7] Nikkei Asia. (2024, April 23). Nikon, Sony and Canon fight AI fakes with new camera tech. Nikkei Asia. https://asia.nikkei.com/Business/Technology/Nikon-Sony-and-Canon-fight-AI-fakes-with-new-camera-tech

[8] BlockTrend. (n.d.). Title of the article. Retrieved from https://www.blocktrend.today/p/593

[9] Respeecher. (n.d.). Addressing Misinformation: Respeecher Content Authenticity Initiatives. Retrieved from https://www.respeecher.com/blog/addressing-misinformation-respeecher-content-authenticity-initiatives-partnership-for-authentic-digital-content